大数据的并行计算框架包括

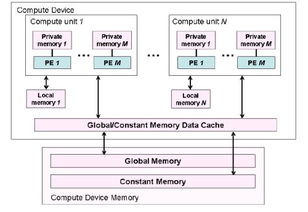

大数据并行编程模型指的是一种分布式计算的编程模型,旨在解决大规模数据处理和分析的性能瓶颈问题。它可以将数据分配到多个计算节点上并进行并行计算,从而提高计算效率和可扩展性。常见的大数据并行编程模型有如下几种:

1. MapReduce模型:MapReduce是一种用于大规模数据处理的编程模型,由Google公司提出,是大数据处理的基本框架,并且被广泛应用。这个模型将数据分为多个块,然后在集群中的各个节点上进行并行处理,最后再进行聚合输出。MapReduce模型主要包含Map和Reduce两个阶段,Map阶段对数据进行处理和分析,Reduce阶段对Map阶段处理的结果进行汇总和输出。MapReduce的并行化思想得以很好地实现了。

2. Spark模型:Spark也是分布式计算框架,可以支持大规模数据处理、即时计算和交互式查询。Spark模型和MapReduce模型类似,也是将数据分块并在集群中的各个节点上进行并行处理,但Spark模型在内存计算方面优势明显,可大量减少IO时间,因此速度更快。

3. Storm模型:Storm模型是一种流式计算的编程模型,适用于实时计算并流式处理数据。相对于MapReduce和Spark模型,Storm模型更注重应用实时性,可以实时处理数据流并快速做出响应。

这些大数据并行编程模型都有各自的特点和优势,能够满足大规模数据处理和分析的需要。但无论采用哪种模型,都需要依赖于分布式存储系统,如分布式文件系统HDFS等,并且需要合理设计数据分割策略和任务调度方式,以最大程度地发挥并行化处理的效果。

免责声明:本网站部分内容由用户自行上传,若侵犯了您的权益,请联系我们处理,谢谢!联系QQ:2760375052 沪ICP备2023024866号-10

评论